For nylig er vi stødt meget på sætningen LiDAR-sensor i artikler om kameraer på nye Apple-enheder. Denne sætning er kastet rundt så meget, at vi glemmer, at Augmented Reality-telefoner kan fungere på enhver måde, især med ToF-værktøjer, der tager Samsung-telefoner til næste niveau.

Så hvor er forskellen mellem LiDAR og ToF? Lad os finde ud af det med Quantrimang.

Hvad er ToF?

ToF står for Time of Flight. Faktisk involverer ToF lysets hastighed (eller endda lyd) for at bestemme afstanden. Den måler den tid, det tager for lys at forlade enheden, nå objektet og vende tilbage, alt sammen opdelt i to perioder, der angiver afstanden fra enheden til objektet eller overfladen.

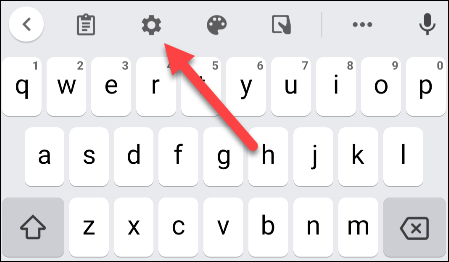

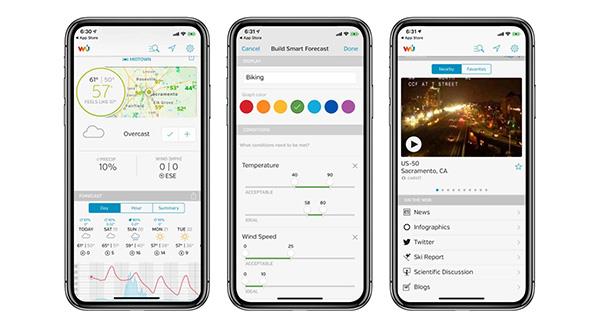

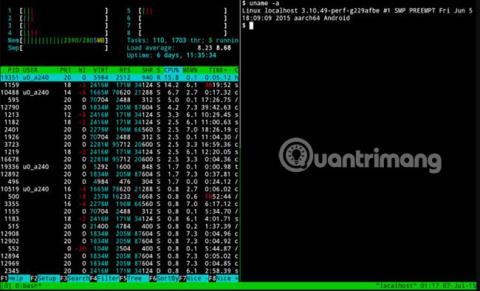

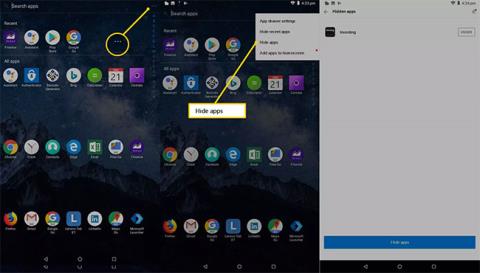

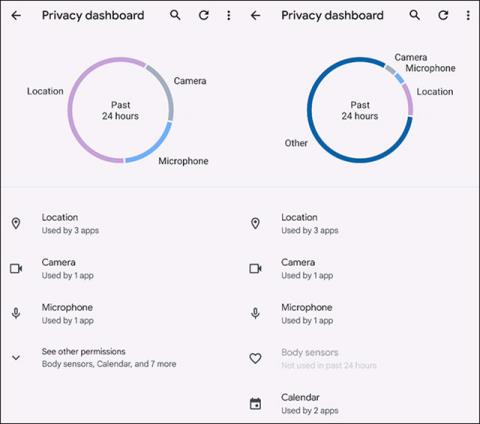

Android-enheder bruger ToF-sensorer

Så al LiDAR er en type Time of Flight, men ikke alle ToF er LiDAR. Kort sagt betyder ToF optisk afstandsmåling, som ikke er relateret til LiDAR.

Hvad er LiDAR?

LiDAR står for Light Detection and Ranging. Denne teknologi bruger en laser eller en laserstråle samt en lignende lyskilde som ovenfor.

LiDAR sensor på iPhone

En enkelt LiDAR-sensor kan bruges til at måle bredden af et rum, men flere LiDAR-sensorer kan bruges til at skabe en "punktsky". Disse punkter bruges til at skabe en 3D-model af et objekt eller et topografisk kort over et helt område.

Selvom LiDAR kan være nyt for mobile enheder, har teknologien faktisk eksisteret i et stykke tid. Når det ikke er installeret på en telefon, bruges LiDAR til at gøre alt fra kortlægning af undervandsmiljøer til arkæologiske steder.

Forskellen mellem LiDAR og ToF

Den funktionelle forskel mellem LiDAR og andre former for ToF er, at LiDAR bruger en pulseret laser til at bygge en "punktsky", som derefter bruges til at bygge et kort eller 3D-billede. ToF-applikationer skaber "dybdekort" baseret på lysdetektion, ofte gennem et standard RGB-kamera.

Fordelen ved ToF frem for LiDAR er, at ToF kræver mindre specialiseret udstyr, så det kan bruges med små og billigere enheder. Fordelen ved LiDAR kommer fra, at computere nemt kan læse punktskyer i forhold til dybdekort.

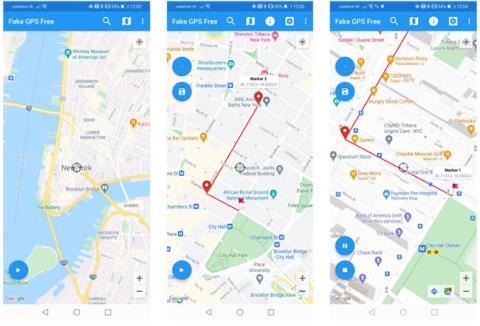

Dybde-API'en, som Google skabte til Android, fungerer bedst på enheder, der understøtter ToF, ved at skabe et dybdekort og genkende "feature points". Disse trækpunkter er ofte barrierer mellem forskellige lysintensiteter, som derefter bruges til at definere forskellige planer i miljøet. Dette skaber i det væsentlige en punktsky med lavere opløsning.

Sådan fungerer ToF og LiDAR med mobil AR

Dybdekort og punktskyer er fantastiske, og for nogle brugere er det nok. For de fleste AR-applikationer skal disse data dog kontekstualiseres. Både ToF og LiDAR opnår dette ved at arbejde sammen med andre sensorer på mobile enheder. Specifikt skal disse platforme forstå din telefons orientering og bevægelse.

Er LiDAR bedre end ToF?

For at være præcis er LiDAR hurtigere og mere præcis end ToF. Dette bliver dog vigtigere med nye teknologiapplikationer.

For eksempel har Googles ToF og Depth API'er svært ved at forstå store, lavteksturplaner som hvide vægge. Dette kan gøre det vanskeligt for applikationer, der bruger denne metode, at placere digitale objekter nøjagtigt på bestemte overflader i den fysiske verden. Applikationer, der bruger LiDAR, er mindre tilbøjelige til at have dette problem.

Imidlertid vil applikationer, der involverer strukturelt forskelligartede eller større miljøer, sandsynligvis ikke opleve dette problem. Desuden bruger de fleste mobilbaserede forbruger-AR-applikationer AR-filtre på brugerens ansigt eller krop – en applikation, der sandsynligvis ikke vil støde på problemer på grund af store overflader.

Hvorfor bruger Apple og Google forskellige dybdesensorer?

I forbindelse med udgivelsen af LiDAR-kompatible enheder siger Apple, at det har kombineret sensorerne med hardware for at "åbne mere professionelle arbejdsgange og understøtte professionelle foto- og videoapplikationer." Den LiDAR-kompatible iPad Pro er "verdens bedste enhed til augmented reality", og lanceringsproduktet inkluderer Apples måleapps.

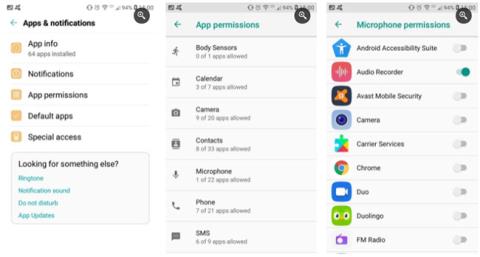

Google forklarer udførligt, hvorfor deres Depth API og den nye linje af understøttende enheder ikke bruger LiDAR. At arbejde med LiDAR holder Android-enheder lettere og mere overkommelige, plus der er en stor fordel i tilgængelighed.

Da Android-telefoner fremstilles af mange virksomheder, vil LiDAR-adoption favorisere LiDAR-kompatible modeller frem for andre. Desuden, fordi det kun kræver et standardkamera, er Depth API bagudkompatibel med flere enheder.